当地时间12月10日,人工智能领域全球顶级学术会议 NeurIPS (Annual Conference on Neural Information Processing Systems) 在加拿大温哥华正式召开。官方数据显示,NeurIPS 2024共收到超一万五千篇有效论文投稿,投稿量创新高,参会人数超万人规模。

阿里云 PAI 团队的论文《PertEval: Unveiling Real Knowledge Capacity of LLMs with Knowledge-Invariant Perturbations》被 NeurIPS D&B Track 2024 收录,并被列为 Spotlight,本年度 NeurIPS 的 Spotlight 论文录取率仅为3%。论文通过对大语言模型真实知识能力的评估,揭示现有静态评测集指标的可信性问题以及大语言模型知识掌握中的各种弱点,并指导改进的发展。

同时,在本次会议中,PAI 团队为参会者带来主题演讲分享、AI 工程化平台产品能力 Demo。演讲分享的议题为“可信 AI 的技术解读与最佳实践”,深入研讨在大语言模型广泛应用的当下,如何保障使用 AI 全流程的安全、可靠和可信。

中选论文

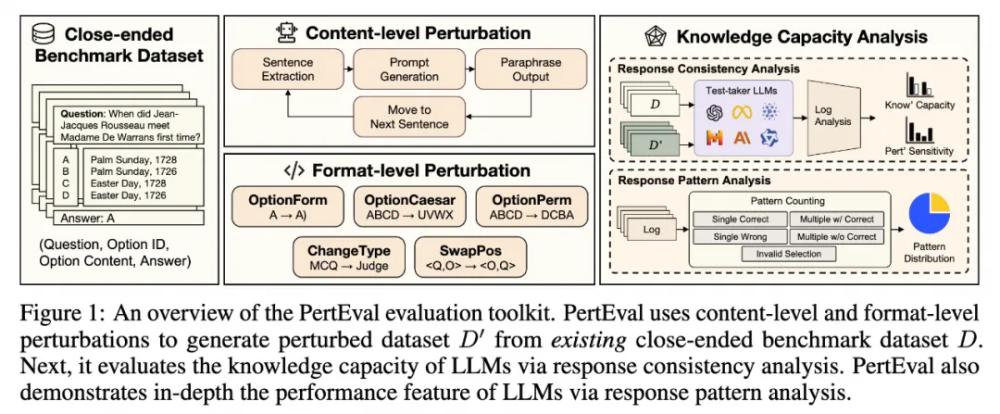

论文《PertEval: Unveiling Real Knowledge Capacity of LLMs with Knowledge-Invariant Perturbations》被 NeurIPS 2024 收录,并入选 Spotlight。PertEval 是一款大型语言模型评估工具包,通过引入“知识不变扰动”的创新概念,对静态基准(static benchmarks)进行改写,从而更准确地揭示大型语言模型(LLMs)的真实知识能力。

革新评估方式,提升可信度

传统上,评估 LLM 性能的方法依赖于静态基准测试,例如 MMLU 和 C-Eval 等,这些方法虽然广泛使用,但存在明显的局限性和数据污染风险,导致对模型真实能力的认知失真。PertEval 通过应用知识不变扰动,确保了在不改变模型所识别和应用的知识前提下,对原始评估问题进行修改。这种方法缓解了由于记忆效应和数据污染造成的评估失真问题,显著提高评估结果可靠性。

揭示现有评估方法的不足

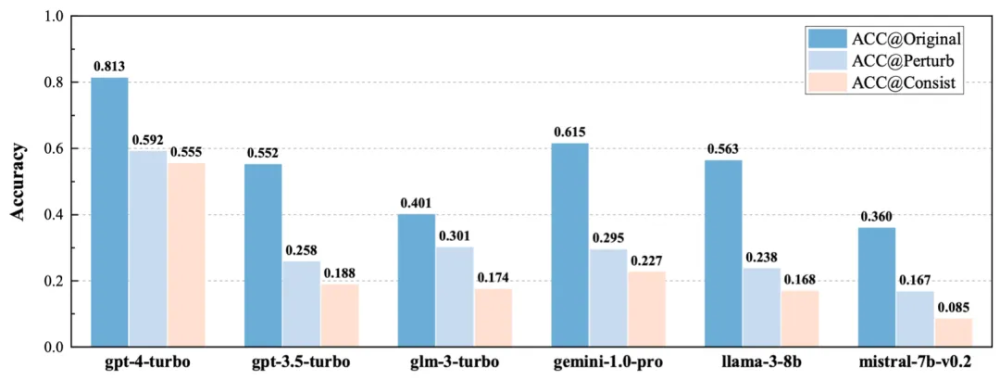

研究团队利用 PertEval 重新评估了六个代表性的 LLM,包括 GPT-4,并发现这些模型在MMLU 等静态基准上的表现被显著高估,其中 GPT-4 的表现被绝对高估了26%。进一步分析显示,这种虚高的性能主要源自 LLM 面对不确定知识时表现出的犹豫不决,以及对正确答案的死记硬背现象。这表明当前的评估方法可能无法充分反映 LLM 在实际应用中的表现。

推动行业进步,指导未来研究

这项研究表明,为了更好地理解和改进 LLM 的能力,需要一种能够体现其真实性能的评估方法。PertEval 提供了一种新的视角和工具,以帮助研究人员和开发者更准确地评估和优化 LLM。后续,计划将 PertEval 整合到 PAI 平台中,支持一键式开启任意模型(无论是 API、开源还是微调后的模型)的真实能力评估。此外,还将通过 leadboard 的方式向开发者社区反馈主流 LLM 的“知识能力”度量,促进整个行业的健康发展。

PertEval 的推出标志着在提升 LLM 评估准确性方面迈出的重要一步,为推动 AI 技术的进步提供了有力的支持。随着这一工具的广泛应用,我们期待看到更加可靠和公平的模型评估标准,以及由此带来的技术创新。

论文标题:PertEval: Unveiling Real Knowledge Capacity of LLMs with Knowledge-Invariant Perturbations

论文作者:Jiatong Li, Renjun Hu, Kunzhe Huang, Yan Zhuang, Qi Liu, Mengxiao Zhu, Xing Shi, Wei Lin

论文地址:https://arxiv.org/abs/2405.19740

演讲分享

演讲标题:可信 AI 的技术解读与最佳实践

Core Technical Interpretation and Best Practices of Responsible AI

演讲人:林伟 | 阿里云智能集团研究员、人工智能平台 PAI 负责人

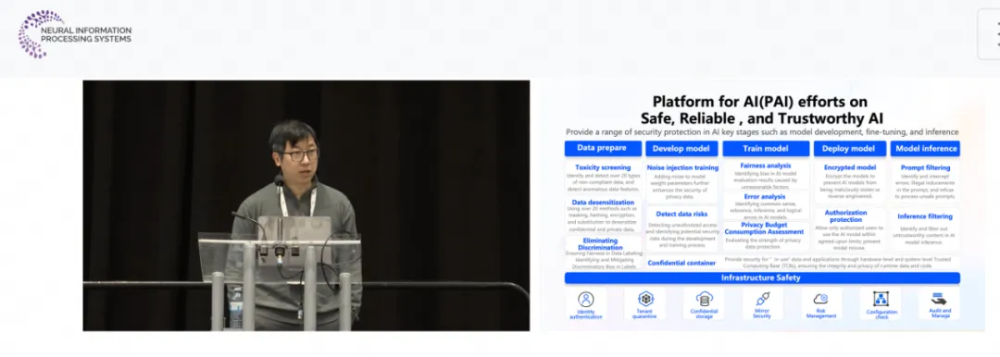

演讲为 NeurIPS 参会者带来阿里云人工智能平台 PAI 的企业级可信 AI 解决方案以及技术解析。PAI 平台提供的安全、可靠和可信的 AI 解决方案,通过确保数据合规与安全、算法稳健性与可靠性、模型可信度和基础设施安全与稳定性这四大关键要素得以实现。为实现可信 AI,PAI 团队创新性地提出了 T 型安全架构。从垂直的角度考虑,从下至上保障云计算基础设施、数据和模型、AI 应用的安全;从水平的角度考虑,覆盖数据准备、模型训练和模型部署的 AI 开发全链路。目前,可信 AI-公平性分析、可信 AI-错误分析功能均已上线,欢迎您前往阿里云人工智能平台 PAI 体验。

更多原理介绍和操作步骤,请参考产品文档 「人工智能平台 PAI-Responsible AI」:https://help.aliyun.com/zh/pai/use-cases/responsible-ai。

产品能力展示

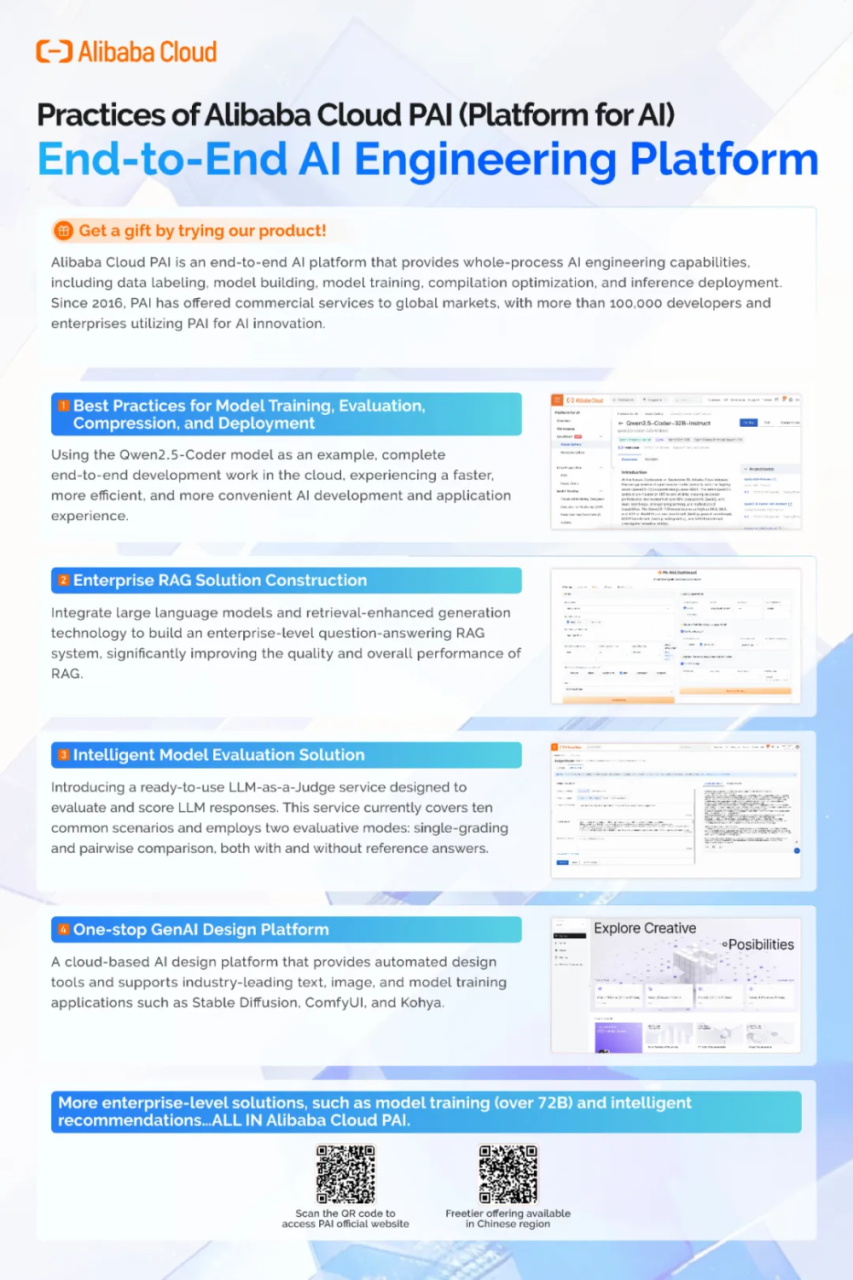

主题:AI Native 的大模型与 AIGC 工程平台

阿里云人工智能平台 PAI 提供包含数据集管理、算力管理、模型工具链、模型开发、模型训练、模型部署、AI 资产管理在内的功能模块,内置100+种大模型最佳实践,为用户提供高性能、高稳定、企业级的大模型工程化能力。在本次平台产品能力 Demo 环节,人工智能平台 PAI 为大家带来包含以下多个实操展示:

1、以 Qwen2.5-Coder 为例,完成大语言模型微调训练、部署和评测

2、通过 PAI-EAS,搭建企业级大模型 RAG 对话系统

3、通过 PAI-裁判员模型,实现高效易用的智能模型评测

4、通过 PAI-Artlab,体验自动化的一站式 AIGC 设计平台

现场数百位参会者体验 PAI 平台的能力。目前,所有 Demo 均已在线上开放,欢迎您前往阿里云人工智能平台 PAI 体验。

如您对我们的论文或产品感兴趣,或希望加入我们,欢迎您前往 NeurIPS2024 - Alibaba Cloud 展台深入交流(West Hall A-Sponsor Exhibit Hall booth 143),期待您的到来!